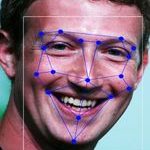

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte, las ik bij Tweakers. Mevrouw Bachelet doet deze uitspraak in een rapport van de Verenigde Naties waarin de effecten van artificiële intelligentie op mensenrechten wordt besproken. Overheden zouden eerst moeten kunnen aantonen of er voldaan wordt aan de privacywetgeving en of er niet gediscrimineerd kan worden. En dat geeft weer gelijk discussie over de vraag of een AI wel kan discrimineren.

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte, las ik bij Tweakers. Mevrouw Bachelet doet deze uitspraak in een rapport van de Verenigde Naties waarin de effecten van artificiële intelligentie op mensenrechten wordt besproken. Overheden zouden eerst moeten kunnen aantonen of er voldaan wordt aan de privacywetgeving en of er niet gediscrimineerd kan worden. En dat geeft weer gelijk discussie over de vraag of een AI wel kan discrimineren.

Het rapport stipt nog meer dingen aan, zoals dat AI vaak door private partijen wordt geleverd en dan totaal niet transparant is. Of dat je niet weet waar de data vandaan komt of wat men er nog meer mee doet. Ik vind dat soort dingen minstens zo ingewikkeld en juridisch vervelend.

Maar goed, discriminatie. Gewoon een neutraal woord in de wetenschap hoor, zo lees ik dan in de comments. En terecht: het betekent gewoon “onderscheid maken” en in de statistiek gebruik je dat voor iedere situatie waarin je data in groep A of B gaat onderverdelen. Maar juristen en ethici bedoelen er wat anders mee, namelijk het onderscheid maken op basis van verboden kenmerken zoals etnische afkomst, seksuele gerichtheid of politieke voorkeur. Dat willen we niet, en daar is een hele goede reden voor: deze kenmerken zijn fundamentele waarden van mensen, en ook niet te wijzigen zoals een kledingkeuze of zelfs woonplaats. Daar blijf je dus af.

Bovendien is er nooit enig oorzakelijk verband aangetoond tussen die kenmerken en welk gedrag dan ook. Iedere uitspraak van het soort “mensen met etnisch kenmerk X willen/hebben/kunnen/haten” is dus automatisch fout, dat is gewoon geen kenmerk waar je uitspraken op kunt baseren. Oké, heel misschien medische kenmerken (kroeshaar is lastiger te scheren, Aziaten verdragen koemelk niet) maar dat zijn echt de uitzonderingen. Het soort situatie waar we het bij AI vaak over hebben, past daar niet bij.

Dat wringt, omdat we vaak AI systemen correlaties zien aanwijzen: de criminaliteit is hoger bij groepen met etnisch kenmerk X, sollicitanten met huidskleur A zijn minder geschikt, seksuele gerichtheid X gaat niet samen met lesgeven op school. Voor een AI is dat inderdaad een neutrale constatering, als dat zo in de dataset zit en de functie komt daarbij op een goed werkend onderscheid (de test-dataset wordt correct als ja of nee gesorteerd) dan is het in orde.

Zo’n conclusie is voor de maatschappij echter niet in orde. In eerste instantie niet omdat de dataset waarschijnlijk niet compleet is (dit is namelijk bij vrijwel iedere AI applicatie een ware uitspraak). Maar zelfs als je wél alle relevante data hebt, blijft er een probleem.

Natuurlijk kan een AI ook een bestaande bias blootleggen. Huidskleur blijkt bij dit bedrijf een perfecte voorspeller van geschiktheid, omdat de HR-medewerker die de sollicitanten screende, zelf die bias had. Dan heb je dus een bias geformaliseerd, maar dat kun je het systeem niet verwijten toch? Die geeft neutraal aan hoe de werkelijkheid is, hoe de maatschappij er nu uit ziet.

Maar dat is niet waar. Een mens is allereerst niet zo hard als een AI. Die zal niet snel iemand in zijn of haar gezicht zeggen, je huidskleur past niet bij dit bedrijf. Die verzint excuses, blaast een smetje op het cv op of legt het gewoon op de stapel “tweede keus” wetende dat er al tien mensen op gesprek komen. Dat merk je niet. Een AI zegt gewoon letterlijk waar het op staat, zonder schroom of vergoeilijking of excuses. En dat valt veel meer op, komt veel meer binnen.

Bovendien, en dat vind ik problematischer, heeft een AI veel meer een aura van objectiviteit, betrouwbaarheid, echtheid. De cijfers zeggen het, deze huidskleur kan gewoon niet bij dit bedrijf. Helaas, objectief berekend met 88% betrouwbaarheid en achttien cijfers achter de komma. Maar in feite hebben we hetzelfde als die HR-medewerker die het met mooie smoesjes wist te verhullen.

Arnoud