Een lezer vroeg me:

Recent presenteerde Microsoft een nieuw AI-model, genaamd Vall-E. Dit text-to-speechmodel kan gesproken zinnen in vrijwel ieder stemgeluid genereren na een sample van drie seconden gehoord te hebben. Het AI-model kan daarbij ook intonatie en emotie nabootsen. Is dat strafbaar, als ik het train op iemands stem en die dan van alles laat zeggen?Er is geen stem-equivalent van het portretrecht, dat je een (soort van) algemene zeggenschap over je beeltenis geeft. De positie van de stem in het portretrecht is al lang onderwerp van discussie. Niet met AI, maar gewoon met stem-imitatoren (zoals Gert-Jan Dröge en koningin Beatrix overkwam). De rechtspraak is daar altijd hard in geweest: dat is géén portret, geen afbeelding van die persoon. Laatstelijk nog in 2020, toen een vrouw probeerde zich te verzetten tegen gebruik van een audiofragment van haar stem.

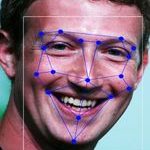

Dat vonnis maakte wél duidelijk dat een stemgeluid een biometrische persoonsgegeven kan zijn onder de AVG. De definitie (artikel 4 lid 4 AVG) noemt als voorbeelden wel “gezichtsafbeeldingen of vingerafdrukgegevens” maar ik zie geen bezwaar tegen een herkenbare uitspraak van iemand op een lijn te zetten met een portretfoto of vingerafdruk. De Franse toezichthouder ziet dit ook zo.

Natuurlijk moet het stemgeluid wel herleidbaar zijn, de persoon er achter moet te identificeren zijn. Dat is bij een willekeurig stukje geluid opgenomen in een winkelstraat erg lastig. Maar bij zo’n online geluid dat uit een AI komt is dit een stuk makkelijker – de publicist van het geluid zet erbij wiens stem het is. Ja oké, hij liegt, maar een leugenachtig informatie-element over een persoon is net zo goed een persoonsgegeven.

Een onjuist (want leugens bevattend) persoonsgegeven zou te corrigeren of te verwijderen moeten zijn, wat je dus zeggenschap zou geven over zo’n stemopname. Die vrouw uit 2020 had echter pech, omdat bij haar de opname gebruikt werd in een theaterprogramma, en dat is een verwerking voor artistieke doeleinden. Die zijn net als journalistieke verwerkingen niet vatbaar voor het recht van correctie of verwijdering.

Het is goed mogelijk dat zo’n AI-stem ook daarvoor wordt gebruikt: laat Mark Rutte wat geks zeggen (u mag zich oud voelen: Tuut tuut tuut, de groeten van …?) of leg Max Schrems wat positiefs over Privacy Shield in de mond en noem het parodie. Als de stem wordt gebruikt om iemand voor gek te zetten zonder enige literaire of artistieke rechtvaardiging, dan is dat wél met de AVG aan te pakken.

Strafbaar is het niet, iemands stem imiteren. Daar kom je pas als je met die imitatie (al dan niet met AI) een strafbaar feit construeert, zoals die persoon zijn reputatie beschadigen of valse bekentenis afleggen (smaad) of de uitspraak gebruiken om fraude te plegen (de directeur imiteren die een frauduleuze betaalopdracht geeft).

Arnoud

Een lezer vroeg me:

Een lezer vroeg me:

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte,

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte,  De Vlaamse kunstenaar Dries Depoorter heeft software gemaakt die via machinelearning en gezichtsherkenning ziet wanneer een politicus op zijn of haar smartphone zit tijdens een overheidsvergadering. Dat

De Vlaamse kunstenaar Dries Depoorter heeft software gemaakt die via machinelearning en gezichtsherkenning ziet wanneer een politicus op zijn of haar smartphone zit tijdens een overheidsvergadering. Dat  GitHub heeft een technische preview uitgebracht van Copilot, een AI-gedreven pair programmer die ontwikkelaars helpt bij het schrijven van code. Dat

GitHub heeft een technische preview uitgebracht van Copilot, een AI-gedreven pair programmer die ontwikkelaars helpt bij het schrijven van code. Dat  De Dienst Speciale Operaties van de Nederlandse politie heeft een Spot-robot van Boston Dynamics in gebruik genomen en die onlangs voor het eerst ingezet. Dat

De Dienst Speciale Operaties van de Nederlandse politie heeft een Spot-robot van Boston Dynamics in gebruik genomen en die onlangs voor het eerst ingezet. Dat  Winkelpersoneel van Albert Heijn is binnenkort in nieuwe bedrijfskleding te zien. De maat zou worden bepaald door foto’s in ondergoed. Dat

Winkelpersoneel van Albert Heijn is binnenkort in nieuwe bedrijfskleding te zien. De maat zou worden bepaald door foto’s in ondergoed. Dat  Een lezer vroeg me:

Een lezer vroeg me: