Een student is erin geslaagd voldoende feiten aan te dragen voor een vermoeden van algoritmische discriminatie, zo maakte het College voor de Rechten van de Mens vorige week bekend. Haar klacht van afgelopen juli kreeg veel aandacht omdat dit zeer zelden gebeurt: de gezichtsdetectieroutine van de antispieksoftware herkende haar aanwezigheid niet, wat haar tentamentijd en stress kostte. Een technisch probleem of discriminatie? We gaan nu horen wat er aan de hand was.

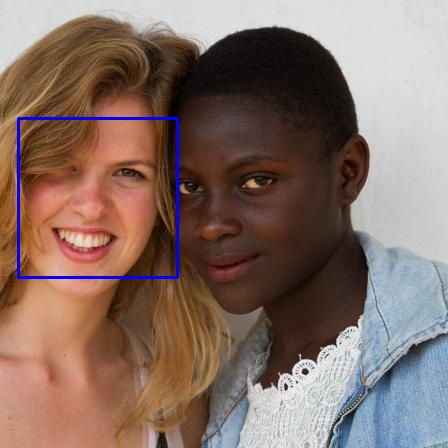

De kern van het probleem is dat antispieksoftware Proctorio deze studente regelmatig niet in beeld herkende (‘face not found’ of ‘room too dark’). Dat leidt tot vertraging en tijdverlies, wat bij een tentamen natuurlijk bepaald ongewenst is. Er is academisch onderzoek (onder meer deze, nonacademisch maar verhelderend is dit onderzoek) dat aantoont dat gezichtsdetectiesoftware over het algemeen slechter presteert op personen met een donkere huidskleur, zodat je goed zou kunnen vermoeden dat dat hier ook speelt.

In een “Statement naar aanleiding berichtgeving Volkskrant” (een titel waar ik gewéldige jeuk van krijg) legde de universiteit destijds uit:

Er is door de faculteit onderzoek gedaan naar aanleiding van de klacht van student van mei 2022 maar er is geen aanwijzing gevonden dat student bij de vijf toetsen in haar klacht meer technische belemmeringen heeft ondervonden dan andere studenten van de inzet van Proctorio. Bij de VU zijn geen andere klachten van vergelijkbare aard door studenten gemeld. Proctorio heeft ons meermalen verzekerd dat er geen verschil is tussen mensen met een donkere of een lichtere huid bij het gebruik van de software.Het College kan niet zo veel met die cijfers van de VU, naast dat het externe onderzoek van Proctorio niet openbaar is:

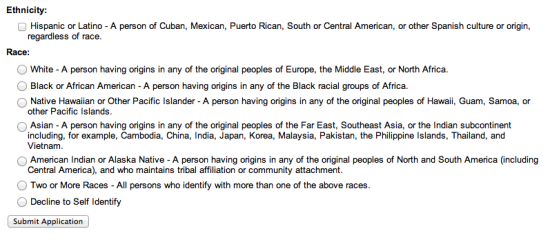

Zo is bijvoorbeeld de gemiddelde inlogtijd van andere studenten niet onderzocht. Daarnaast is het de vraag of deze andere studenten zich in vergelijkbare omstandigheden bevonden als de vrouw.De VU krijgt nu tien weken om aanvullend bewijs te achterhalen waaruit blijkt dat zij geen indirect onderscheid naar ras heeft gemaakt. Dat is dus de juridische frase die in de pers wordt vertaald naar “niet discrimineert”, maar “indirect onderscheid” is wel een stukje breder. “Discriminatie” betekent gewoonlijk dat je bewust – vaak vanuit een superioriteitsgevoel – mensen negatief bejegent op basis van kenmerken zoals ras, geloof of seksuele voorkeur.

“Onderscheid” is een bredere term, die erop neerkomt dat mensen uit een bepaalde groep slechter behandeld worden of meer gedoe hebben. Maar het doet er dan niet toe of jij daar de intentie toe had, zeker bij “indirect” onderscheid. Een voorbeeld van indirect onderscheid is het weigeren van honden in een restaurant – dat treft blinden veel vaker dan ziende mensen. Dat verbod is dan met de beste bedoelingen (hygiëne, rust) maar kan dus niet zonder een uitzondering voor hulphonden, die dan op hun beurt weer rustig onder tafel moeten kunnen blijven.

Ik geloof zelf geen seconde dat de VU bewust dacht “mensen van kleur verdienen gedoe bij hun tentamens”. Dus “discrimineert men” is niet de juiste vraag. De kern is “zorgde inzet van Proctorio voor meer gedoe bij deze groep dan bij de groep witte mensen” en het antwoord daarop lijkt “ja” te zijn. Dus nu moet de VU hetzij aantonen dat andere groep net zo veel mensen met gedoe hebben hetzij dat het gedoe toch niet te maken heeft met huidskleur.

Een meelezende tweaker suggereerde dat veel studenten (ongeacht afkomst) webcams met veel te lage kwaliteit gebruiken dan wel niet weten hoe deze op te stellen, waardoor detectie natuurlijk óók heel slecht gaat. Dan zou het dus eerder de factor “armoede” dan wel “noob die geen onderscheid weet tussen een aardappel en een Logitech C920” zijn. Het zou me verbazen gezien de algemene bewijzen die juist wél wijzen op huidskleur als factor, maar we gaan het meemaken.

Arnoud

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte,

De commissaris voor mensenrechten bij de VN pleit voor een stopzetting op het gebruik van biometrische herkenning in de publieke ruimte,  Vrijwel standaard hebben alleen mannen bij gemeenten toegang tot belangrijke privégegevens over hun huishoudens, las ik

Vrijwel standaard hebben alleen mannen bij gemeenten toegang tot belangrijke privégegevens over hun huishoudens, las ik  De Duitse krant Bild heeft dinsdag een selectie haatdragende teksten van Facebookgebruikers gepubliceerd – inclusief namen en profielfoto’s. Dat

De Duitse krant Bild heeft dinsdag een selectie haatdragende teksten van Facebookgebruikers gepubliceerd – inclusief namen en profielfoto’s. Dat  De RET heeft een 20-jarige Rotterdammer niet toegelaten tot de opleiding van metrobestuurder omdat hij een racistisch bericht op Twitter verstuurde,

De RET heeft een 20-jarige Rotterdammer niet toegelaten tot de opleiding van metrobestuurder omdat hij een racistisch bericht op Twitter verstuurde,  Hoe zet je Facebook-advertenties optimaal in om de juiste kandidaat te vinden, las ik

Hoe zet je Facebook-advertenties optimaal in om de juiste kandidaat te vinden, las ik

Bij het onvolprezen Retecool las ik woensdag een

Bij het onvolprezen Retecool las ik woensdag een