Een Amerikaanse rechter heeft geweigerd dat een video als bewijs wordt gebruik in een rechtszaak vanwege het gebruik van AI-software bij het bewerken van de video. Dat meldde Tweakers vorige week. Door gebruik van de software wilde de aanklager duidelijker maken dat het inderdaad ging om de verdachte.

Wat ging er nou precies mis?

De aanklager gebruikte Topaz Video AI om de video te upscalen, meldt NBC News. De software van het Amerikaanse bedrijf herkent gezichten en vult vervolgens details aan die niet in het oorspronkelijke beeld zaten. Dat is problematisch, zo redeneert de rechter, want de software ‘leunt op vage methoden om te bepalen wat het AI-model denkt wat we moeten zien’, aldus de rechtbank.Topaz is videobewerkingssoftware: je kunt er beeld mee opknappen, zoals door het er scherper laten uitzien. Dat is mooi voor die vakantiefoto die niet helemaal goed gelukt is, of voor het aanvullen van beeld voor je reclamecampagne dat nét even iets extra’s nodig heeft.

Specifiek bij bewijs is dat allemaal net iets spannender. Het is natuurlijk prima als het bewijs beter te beoordelen wordt, maar dat moet niet gebeuren door er dingen bij te verzinnen, hoe mathematisch logisch het ook lijkt dat die pixels er tussen moeten.

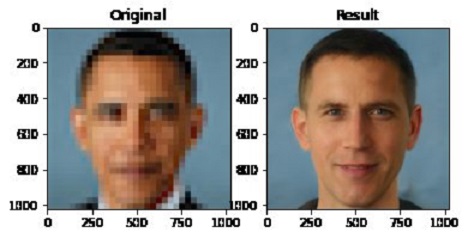

Het plaatje rechtsboven (van een experiment uit 2020 met hetzelfde doel) laat zien waarom: de dataset daarvan bevatte geen gezichten van kleur, waardoor de bekende foto van president Obama opgewerkt werd tot geheel iemand anders. Een recenter voorbeeld was beeldbewerkingssoftware die ongevraagd acteur Ryan Gosling toevoegde aan een video.

Mag dit nou van de AI Act? Ik zit even te peinzen of dit telt als biometrie, maar interpolatie van pixels kan ik moeilijk gelijk stellen aan analyse van gezichtskenmerken. Op de lijst (Annex III) staan wel diverse vormen van AI-gebruik door wetshandhaving, waar naast de politie ook het OM onder valt:

- AI systemen gebruikt als leugendetector

- AI om de betrouwbaarheid van bewijs te evalueren

- AI om recidivisme in te schatten (waarbij meer dan profiling wordt gebruikt, want anders is het verboden)

- AI voor het profileren van mensen in het kader van opsporing en vervolging

Ook zullen dit soort systemen onder de transparantie-eis van “synthetic output generator” AI vallen. Die moeten zorgen dat hun beeld onzichtbaar en robuust gewatermerkt is zodat andere systemen (zoals het uploadformulier van Facebook) kan signaleren dat er synthetische afbeeldingen worden geupload.

Naar de letter van de wet is zulk beeld zelfs een deepfake:

“deepfake”: door AI gegenereerd of gemanipuleerd beeld-, audio- of videomateriaal dat een gelijkenis vertoont met bestaande personen, voorwerpen, plaatsen of andere entiteiten of gebeurtenissen, en door een persoon ten onrechte voor authentiek of waarheidsgetrouw zou worden aangezien;Twintig bij twintig pixels uitvergroot en bewerkt zodat je er Ryan Gosling in ziet, lijkt mij wel “een gelijkenis vertonen” waardoor je ten onrechte het beeld voor waarheidsgetrouw aan gaat zien. Dit beeld moet dus expliciet gemarkeerd worden als niet-authentiek.

Is hiermee alle gebruik van beeldbewerking verboden? Nee. Nog even los van dat dit één uitspraak is; de betrouwbaarheid van via ict verkregen bewijs vaststellen is al decennia een aandachtspunt. AI maakt het manipuleren van bewijs eenvoudiger en sneller, maar dat is geen fundamenteel nieuwe kwestie.

Arnoud

In de Kyle Rittenhouse rechtszaak kwam dit ook al een beetje naar voren. Ze hadden een relatief lage resolutie video van een helikopter. Deze speelde ze af op een groot scherm dat een hogere resolutie had dan de originele video. Vervolgens gingen ze met hun neus op het scherm naar individuele pixels kijken om te beoordelen onder welke hoek Kyle een wapen vast had.

Volgens mij was toen ook de ge-upscalde video geweigerd, maar was er geen bezwaar gemaakt (of die werd ook geweigerd) over de tv. De TV voegt namelijk ook details / pixels toe aan lage resolutie beeldmateriaal. Volgens commentatoren was het daarom ook ongepast om te gaan kijken naar individuele pixels. Het is immers niet te zeggen of die pixels de werkelijkheid zijn.

Een stukje van de video waar het over gaat kan je hier zien: https://edition.cnn.com/2021/11/03/us/kyle-rittenhouse-trial/index.html<\a>

In de Rittenhouse zaak ging het om Apple’s Ipad “Pinch and Zoom” functionaliteit. Apple’s nieuwe software gebruikt mogelijk meer geavanceerde algoritmes dan Nearest Neighbor of Bilinear Interpolation. Bij Nearest Neighbor geef je de pixel waardes van de dichtstbijzijnde pixel aan de nieuwe pixels. Je maakt daarmee het beeld groter, maar voegt verder geen scherpte toe.

Apple geeft niet om bewijsmateriaal, maar om gebruikersgemak: daarom heeft het waarschijnlijk slimme algoritmes die goed werken op gangbare video, het mengt waardes en houd lijnen scherp. In dit geval werd de ge-up-scale-de video frame als bewijs gebruikt voor wapengebruik, en dan zit je al snel in gevaarlijk vaarwater als je scherpe lijnen toevoegt.

In Nederland kent men “vrije bewijsleer”, en heeft de rechter meer speelruimte om bewijs toe te laten of te weigeren. Maar dan nog dient beide bewijs te worden opgeleverd, zijn er (hof)experts die beeldmateriaal gangbaar scherper of makkelijker zichtbaar te maken, en moet transparant zijn wat er precies gebeurd is tijdens opschalen. En dit kan je lastig aantonen als het om bedrijfsgeheim gaat (van Apple, of in deze, Topaz Video AI).

Ik vond het in de Rittenhouse zaak erg schandelijk dat de aanklager zomaar pinch-en-zoom “kijk deze scherpe lijn is een wapen” de jury er naar liet kijken. Gelukkig was de verdediging scherp. In deze is het gewoon grof mishandelen van bewijs, en moet dit afgewezen worden met een waarschuwing; nog een keer, en je wordt geroyeerd! Beetje CSI spelen met het leven van de verweerder…