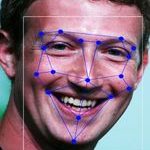

Het gebruik van camera’s met gezichtsherkenning is, zo las ik bij Security.nl meestal niet toegestaan voor bedrijven. Dit volgt uit een recente publicatie van de Autoriteit Persoonsgegevens. De privacytoezichthouder gaat daarom sectoren die dergelijke camera’s vaak gebruiken voorlichting geven over de regels. De Algemene verordening gegevensbescherming (AVG) verbiedt in beginsel het gebruik van biometrische gegevens om iemand te identificeren, maar het gebeurt vaak aldus de toezichthouder: Winkels gebruiken gezichtsherkenningscamera’s om winkeldieven op te sporen, terwijl bedrijven in de beveiliging, beurslocaties en pretparken de technologie inzetten voor toegangscontrole.

Het gebruik van camera’s met gezichtsherkenning is, zo las ik bij Security.nl meestal niet toegestaan voor bedrijven. Dit volgt uit een recente publicatie van de Autoriteit Persoonsgegevens. De privacytoezichthouder gaat daarom sectoren die dergelijke camera’s vaak gebruiken voorlichting geven over de regels. De Algemene verordening gegevensbescherming (AVG) verbiedt in beginsel het gebruik van biometrische gegevens om iemand te identificeren, maar het gebeurt vaak aldus de toezichthouder: Winkels gebruiken gezichtsherkenningscamera’s om winkeldieven op te sporen, terwijl bedrijven in de beveiliging, beurslocaties en pretparken de technologie inzetten voor toegangscontrole.

Het onderwerp is al wel vaker langsgeweest, eind vorig jaar blogde ik over gezichtsherkenning inzetten om een lokaalverbod te handhaven en eerder die sportschool die ’s nachts mensen met gezichtsherkenning binnenliet. De kern van het probleem is dat biometrische gegevens als bijzondere persoonsgegevens gelden, en je daar dus van af moet blijven. Gebruik je foto’s van mensen om ze te herkennen, dan tellen die foto’s als biometrische gegevens (een gewoon kiekje is dus geen biometrisch persoonsgegeven). En dan mag je ze dus niet gebruiken.

Dat ‘herkennen’ moet je breed opvatten: het gaat niet alleen over matchen tegen een database met NAW-gegevens of iets dergelijks. Ook enkel geautomatiseerd constateren “die was hier gisteravond ook” of “die lijkt op foto 31337 uit ons bestand overlastplegers” is al een vorm van ‘herkennen’, waarmee je camerabeelden tot bijzondere persoonsgegevens verworden.

Enige ruimte wordt gegeven door de uitzondering uit artikel 29 Uitvoeringswet: identificatie van de betrokkene die noodzakelijk is voor authenticatie of beveiligingsdoeleinden. En natuurlijk, het doel van deze identificatie (inclusief de 31337-constatering) is voor beveiliging, je wilt overlastplegers, lokaalverbodshouders et cetera niet binnen hebben. Maar is er een nóódzaak? Die vraag is veel lastiger want dat is een hele hoge lat.

Kort gezegd moet er dan geen ander middel voorhanden zijn dat ongeveer zo effectief is, en de maatregel moet ook proportioneel zijn. De AP gaat zelfs nog een stapje verder:

Het moet daarbij wel gaan om een zwaarwegend algemeen [italics AE] belang. Dat is bijvoorbeeld de beveiliging van een kerncentrale. Maar de beveiliging van bijvoorbeeld een supermarkt is niet zó belangrijk dat u daarvoor biometrische gegevens mag verwerken.Dat algemeen belang haal ik zo niet uit de Uitvoeringswet, maar het is natuurlijk waar dat beveiligen van één winkel geen algemeen belang dient. Ik had zelf altijd het idee dat ook een individueel belang goed genoeg kon zijn (dit is weer die discussie over legitiem belang, geloof ik), maar dat het misgaat op wat ik de innovatieparadox noem.

De innovatieparadox uit de AVG luidt: nieuwe maatregelen voldoen nooit aan de noodzakelijkheidseis omdat er altijd bestaande maatregelen zijn die goed genoeg zijn. Zet een portier neer die het verbod handhaaft, beveilig je supermarkt met detectiepoortjes, doe toegangscontrole met tickets op naam, et cetera. Natuurlijk zitten daar kosten aan, maar zeker in het begin zitten die er ook aan camera-identificatie – aanschaf, onderhoud, testen en beveiligen bijvoorbeeld. Dus “dit is veel goedkoper” is geen argument.

Oftewel: hoe betoog je dat een nieuwe manier van persoonsgegevens verwerken acceptabel is, als deze net zo duur is en zich nog niet bewezen heeft in de praktijk?

Arnoud

In het geval van de sportschool; vreemd eigenlijk, dat een portier die gezichten herkent en (voor altijd) onthoudt en bovendien vrij arbitrair bepaalt of iemand misschien wel een boef is, wel mag. Een camera systeem dat GEEN nieuwe gegevens opslaat maar alleen realtime vergelijkt met bestaande data (met toestemming van die personen zelf) mag niet.

Een portier die voor ‘altijd onthoud’ Je zou je eens in het geheugen moeten verdiepen. Want mensen onthouden maar maximaal 11 jaar iets. Mocht je dat ‘iets’ langer hebben onthouden dan is dat gekomen door de associaties die je in die 11 jaar hebt gehad met betreffend onderwerp. Zo niet dan ben je het ‘vergeten’ en zit het niet meer in je geheugen en zal je het opnieuw moeten leren en of de associaties herstellen. .

Het geheugen valt nu eenmaal buiten de AVG.

Dat valt te betwijfelen met deze regering, want de gedachten politie komt steeds dichterbij. Zie de laaste jaren wat er gebeurde met cartoon tekenaars. En wat Grapperhouse graag wil.

MAW nog…. wel.

Het gaat volgens mij om schaalgrootte en om nieuwe toepassingen. Die portier kan niet iedereen in detail onthouden en zal zeker geen grootschalige nieuwe dingen daarmee gaan doen. Een camera schaalt veel harder.

Het is een beetje het verschil tussen een wijkagent die rondjes loopt (fietst) en een serie camera’s die elke straat 24/7 filmt. In beide gevallen zeggen we dat er toezicht is, maar als we per straat een wijkagent neerzetten die de hele dag overal ingrijpt dan zouden we dat disproportioneel vinden. Waarom bij een camera (met live meekijkende centralist) dan niet?

Ik zou dat zeker niet disproportioneel vinden. Ik kan mijn tijd in Amsterdam nog herinnneren met de kevertjes dat je mistens een paar keer per dag of die kevertjes zag en of een aantal agenten op de fiets. Moet er wel bijzeggen dat agenten toen nog wel iets van autoriteit uitstraalden, ipv gijtenwollen sokkenbreiers van nu. (…) Wat mij betreft op staande voet ontslag. Maar ach dat is mijn mening maar

-edit Arnoud passage weggehaald vanwege naar mijn oordeel groepsbeledigende strekking-

Er zou meer maatschappelijk debat moeten zijn over deze kwesties vind ik. Bij het invoeren van dat soort technologie zou de vraag niet alleen moeten zijn “hoe krijgen we dit juridisch voor elkaar”, of “waarom zit die vervelende wet weer in de weg van innovatie”, maar ook “is dit eigenlijk wel iets dat we als maatschappij willen”, en “onder welke omstandigheden”. Ik persoonlijk ben er geen voorstander van; ik krijg een vervelend, beetje dystopisch gevoel van dingen als automatische gezichtsherkenning en biometrische persoonsherkenning. Ik begrijp dat het wellicht noodzakelijk is om zoiets te hebben in de meest uitzonderlijke gevallen, te denken valt dan aan het beveiligen van kernwapens of zo, maar voor normaal, dagelijks gebruik in onze winkelstraten en uitgaanscentra vind ik het veel te ver gaan.

Het is beter dan een portier met een papieren lijst foto’s in zijn hand. Veiliger: Je kunt de gegevens beter beschermen omdat ze op één plaats staan (bij de portier heb je altijd een bestandje plus de kopie die de portier heeft. Het is neutraler: Er wordt door software geen oordeel gevormd zoals een portier dat mogelijk wel doet (bijvoorbeeld alle gekleurde medemensen moeten even wachten terwijl de lijst wordt nagekeken). Het kan zelfs nog veiliger qua opslag: Het is mogelijk dat de software alleen een digitale vingerafdruk van een gezicht opslaat (haha, vingerafdruk. ook biometrisch). Nee, een digitale vingerafdruk waarmee je het gezicht niet kunt achterhalen; je kunt het alleen herkennen als het voor je camera staat. Maar als het bestand gestolen wordt kun je er geen foto’s uit halen.

Zoals Arnoud aal aangeeft, het is juist de centralisatie en het bulkverwerken dat het probleem is, en beveiliging hangt nog steeds af van mensenwerk. En of het neutraler is: we hebben al een heel aantal keren software voorbij zien komen die met de verkeerde data gevoed ongeneerd racisitisch bleek te zijn.

En foto’s terugherleiden uit een hash over genormaliseerde gezichtskenmerken: een kwestie van brute-forcen, van vrijwel iederreen is wel een fotootje te vinden.

Eens met Gregorius dat een maatschappelijk debat over dit soort zaken gewenst is. Ik denk namelijk dat bepaalde biometrische identificatiesystemen acceptabel geacht worden, terwijl andere niet acceptabel gevonden zullen worden. De Privium irisscan draait al aardig wat jaren op Schiphol en ik heb van niemand gehoord dat die afgeschaft moet worden.

Als we het over toegangssystemen hebben zijn er verschillende varianten mogelijk:

a) een systeem met centrale opslag dat alleen op basis van biometrie doorlaat of weigert,

b) een systeem met een combinatie van pas en biometrische herkenning met centrale opslag,

c) een systeem met combinatie van pas en biometrie, waarbij de biometrische gegevens op de pas staan.

Ik vind c) uit privacy-oogpunt aanzienlijk acceptabeler dan a) en b) (Moeten er wel waarborgen zijn die centrale opslag voorkomen.) Maar voor het gemak van optie a) is ook wel wat te zeggen, al zie ik daar de fundamentele vraag of een persoon (of organisatie) voor anderen de afweging tussen privacy en gemak mag maken.

c bestaat allang. Die photo zit in je paspoort en die staat oa in London City bij de paspoort controle. Pas op de scanner (die zoekt scant de pagina, pikt geboorte/verval datum en passpoort nummer leest daarmee de foto uit de nfc chip) en in de camera kijken en poortje gaat open.

Kun je zelf ook met deze android app eCL0WN: an NFC passport tool

Bij het paspoort speelt dan wel het probleem dat jouw foto ook door de overheid centraal wordt opgeslagen, hetgeen voor decentrale toegangscontrole niet nodig is.

Niet om weer de zoute jongen in het commentaar te spelen hoor, maar ik zie de paradox niet. Je kan toch prima stellen dat de verwachting is dat het systeem over periode Y met factor X efficiënter, goedkoper, etc. zal uitvallen en die berekening meenemen in de belangenafweging? Het probleem dat je beschrijft is eigenlijk dat zo’n systeem wordt geïnstalleerd terwijl niemand eigenlijk weet of en waarom het überhaupt zoveel beter zal uitpakken, waardoor je zo’n belangenafweging moeilijk rondkrijgt.

Maar als je echt zoveel moeite hebt met beargumenteren waarom iets een ‘innovatie’ is dan is het dat waarschijnlijk gewoon niet. Dat kan wellicht niet het antwoord zijn waar men naar op zoek is, maar daar zie ik geen paradox in. Je zegt het zelf ook; dat de supermarkt op de hoek graag een AI beveiligingssysteem wil installeren dat klanten nauwgelet volgt en profileert omdat het op termijn nou eenmaal handiger is vindt ik gewoon geen reden om het ook toe te laten.

Met andere woorden; dat hier besproken maatschappelijk debat over wenselijkheid hebben we indirect al gevoerd en de uitkomst daarvan is gewoon gecodificeerd in de afwegingen van de AVG. Als die afweging negatief uitvalt voor jouw fantastische biometrische systeem betekent dat niet dat de AVG heeft gefaald of dat die afweging eindeloos over moet totdat je een omweg hebt gevonden, dan doe je het maar gewoon niet.

Ik las laatst dat programma’s als Zoom met name biometrice face-recognition programma’s op de achtergrond laten lopen om zo die programma’s verder te ontwikkelen. Natuurlijk zijn dit Amerikaanse leveranciers / ontwikkelaars en hun recht baseert zich erop dat Amerikanen altijd alle rechten hebben en de buitenlanders alleen verplichtingen, maar kan dit eigenlijk wel echt? Staat de Nederlande – lees Europese – wetgeving helemaal machteloos en had niet uitdrukkelijk melding moeten worden gemaakt van deze functie?

Hoe betrouwbaar is de bron van dat bericht? Ik geef toe dat het technisch kan, maar dat wil nog niet zeggen dat het de gebruikelijke praktijk is. Volgens EU recht mag zoiets niet zonder voorafgaande toestemming en ook in de VS wordt het delen van privégesprekken met derden niet getolereerd.