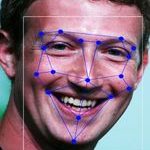

De Zweedse politie heeft van de Zweedse privacytoezichthouder een boete van 250.000 euro opgelegd gekregen wegens het onrechtmatig gebruik van het gezichtsherkenningssysteem van het bedrijf Clearview AI. Dat meldde Security.nl onlangs. “De politie heeft onvoldoende organisatorische maatregelen ingevoerd om ervoor te zorgen dat het verwerken van persoonlijke data in dit geval volgens de wet plaatsvond”, aldus de Integritetsskyddsmyndigheten (IMY). Zo ontbrak een DPIA. Maar, zo lees ik op diverse plekken, wat is nu het probleem want de politie gebruikt dit toch alleen als hulpmiddel voor eerste leads?

De Zweedse politie heeft van de Zweedse privacytoezichthouder een boete van 250.000 euro opgelegd gekregen wegens het onrechtmatig gebruik van het gezichtsherkenningssysteem van het bedrijf Clearview AI. Dat meldde Security.nl onlangs. “De politie heeft onvoldoende organisatorische maatregelen ingevoerd om ervoor te zorgen dat het verwerken van persoonlijke data in dit geval volgens de wet plaatsvond”, aldus de Integritetsskyddsmyndigheten (IMY). Zo ontbrak een DPIA. Maar, zo lees ik op diverse plekken, wat is nu het probleem want de politie gebruikt dit toch alleen als hulpmiddel voor eerste leads?

De database van Clearview is opgebouwd door het scrapen van zo ongeveer alle social media sites, van Facebook tot Instagram en Venmo. En omdat die allemaal een Real Name Policy hebben, heb je een handige herkenningstool. Overheden leken de aantrekkelijkste doelgroep voor de dienst, dus daar is men heen gepivot en daarom lezen we nu dat er al tientallen zaken zijn opgelost van het soort waarvan je denkt “als ze nou toch de foto eens door Facebook heen konden halen dan hadden ze ‘m zo, de naarling”.

Nou ja, zoals ik vorig jaar zei:

[V]an bronnen blijf je af tenzij je kunt bewijzen dat je erin mag en dat je mag doen wat je van plan bent. En dat gaat natuurlijk hartstikke mis: die gegevens staan daar niet zodat Clearview er een matching tool mee kan maken maar omdat mensen zichzelf op social media willen presenteren. Dat is dus een doelbindingsprobleem, in het jargon. Ook gaat het mis met de informatieplicht: Clearview vertelt niemand dat hun foto in hun bestand verwerkt wordt en dat er matches zijn gedaan door politiediensten of andere snuffelaars. Dat is onderdeel van de transparantie die de AVG eist.Dit zijn natuurlijk fundamentele bezwaren, maar ze zijn ook vrij abstract. En dat is lastig want het tegenargument is natuurlijk, als het de politie helpt een lead te vinden dan is dat toch mooi? Wat Clearview doet, is immers ‘gewoon’ dertig matches geven van mensen die lijken op de verdachte, met naam en Facebookprofiel er bij. Die namen trek je dan alsnog zelf door de politiesystemen. Hoe is dat anders dan een buurtonderzoek waarbij iemand zei dat zhij Wim ten Brink had gezien op de plaats delict?

Nou ja, dat is anders omdat je bij buurtonderzoek als agent zelf filtert. Je vraagt het aan mensen uit de buurt, je weet dat wat je binnenkrijgt een tip is zonder onderbouwing en je gaat dat zelf combineren met andere informatie. Dat in tegenstelling tot Clearview, dat pretendeert ‘echte’ matches te geven en daarmee hoge betrouwbaarheid suggereert.

Ook is het met zulke systemen mogelijk dat een vals positief wordt gegeven, waar je dan geen indicatie van hebt. Want die persoon lijkt wel natuurlijk, dus die moeten we het toch maar eens even gaan vragen. En dan krijg je een bekende valkuil, namelijk dat als je iemand als mogelijke verdachte benadert, je eerder bevestiging ziet van dat beeld.

Dit nog los van het feit dat Clearview zelf ook weer met de informatie aan de slag gaat – en hoezo mag een privaat bedrijf weten welke personen de politie zoekt?

Arnoud

AI-software blijkt net zo goed als een groep willekeurige mensen in het voorspellen van recidive bij Amerikaanse veroordeelden,

AI-software blijkt net zo goed als een groep willekeurige mensen in het voorspellen van recidive bij Amerikaanse veroordeelden,