De Ierse privacytoezichthouder DPC heeft noyb, de organisatie van privacyactivist Max Schrems, een take down request gestuurd waarin wordt verzocht een document te verwijderen. Dat meldde Security.nl vorige week. Het document is het conceptbesluit op noyb’s handhavingsverzoek tegen Facebook, waarin een opmerkelijke interpretatie van de AVG wordt geïntroduceerd die een joekel van een loophole oplevert. De DPC wil deze publicatie offline omdat ze interfereert met het overlegproces om het besluit te finaliseren.

Er is al jaren kritiek op de Ierse privacytoezichthouder omdat het niet zou optreden tegen techbedrijven, die vaak in Ierland hun Europees hoofdkantoor hebben. Iets wat de DPC ontkent. De nieuwe kritiek gaat over de opmerkelijke draai die Facebook op 25 mei 2018 maakte: vanaf toen hoefde niemand meer toestemming te geven onder de AVG voor wat Facebook deed, dat was sindsdien namelijk allemaal een noodzakelijk deel van de dienstverlening en voor verwerkingen die nodig voor een contractsuitvoering zijn, is geen toestemming nodig.

Ik ken werkelijk niemand behalve Facebook die met een serieus gezicht volhoudt dat “als wij in de voorwaarden zetten dat het nodig is, dan is het nodig” een valide interpretatie van de AVG is. Maar goed, nu dus de Ierse toezichthouder ook. Ik snap dus wel dat iemand als Schrems daar een publicatie over doet.

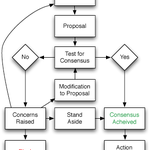

Dat valt juridisch een beetje slecht, want formeel is deze interpretatie van de DPC (disclaimer: er zijn geen aanwijzingen dat Facebook het conceptbesluit heeft voorgekookt of geschreven) slechts een concept, dat nu gedeeld wordt met belanghebbenden en andere toezichthouders, die dan commentaar mogen leveren, waarna er een definitief, openbaar besluit komt. Het is niet heel gebruikelijk dat conceptbesluiten in de pers komen, want er kunnen immers fouten in staan, slordigheden en ga zo maar door. Precies daarom wil je feedback verwerken voor je het besluit oplegt.

In veel procedures zijn dan ook expliciete geheimhoudingsregels opgenomen. De AVG kent die niet, en ook in de Ierse Uitvoeringswet AVG kan ik zoiets niet vinden. De DPC verwijst naar artikel 26 daarvan, maar zo te lezen gaat dat alleen over medewerkers van de DPC. Desondanks is de takedownbrief heel stellig: weg met die publicatie, en wel meteen. Maar wie als cynische jurist leest, komt tot de conclusie dat er veel bangmakerij staat maar géén “op grond van artikel 26 van de wet beveel ik u”. En reken maar dat een jurist die zin opneemt als hij daar aanleiding toe ziet, weinig dingen zo heerlijk als keihard in je recht te staan en met wapperende toga de wederpartij tot de orde te roepen.

De discussie wordt wat complex omdat noyb in de eerdere onderzoeksfase had toegezegd documenten vrijwillig geheim te houden om het onderzoek niet te schaden. De DPC citeert passages van noyb die zonder voorbehoud lijken te zeggen dat men die documenten gewoon, altijd geheim zal houden. noyb stelt daar tegenover dat de volledige toezeggingsmails duidelijk maken dat het alleen ging om de onderzoeksfase, die ondertussen allang is afgerond.

Ondertussen is het mij een raadsel wat de DPC dacht te bereiken nu hun conceptbesluit al wereldnieuws bleek te zijn geworden toen men de boze brief ging sturen.

Arnoud

De Autoriteit Persoonsgegevens gaat toezien op het gebruik van kunstmatige intelligentie (AI) en algoritmes waarbij persoonsgegevens worden gebruikt. Dat

De Autoriteit Persoonsgegevens gaat toezien op het gebruik van kunstmatige intelligentie (AI) en algoritmes waarbij persoonsgegevens worden gebruikt. Dat  Facebook moet WhatsApp-data wissen van Duitse privacywaakhond,

Facebook moet WhatsApp-data wissen van Duitse privacywaakhond,  Een drone met camera moet een encrypted filesystem hebben, en wie met een dashcam gaat rijden, moet eerst in de buurt gaan flyeren dat hij rondrijdend cameratoezicht gaat toepassen. Dat maak ik op uit de nieuwe

Een drone met camera moet een encrypted filesystem hebben, en wie met een dashcam gaat rijden, moet eerst in de buurt gaan flyeren dat hij rondrijdend cameratoezicht gaat toepassen. Dat maak ik op uit de nieuwe