OpenAI werkt aan een zakelijke, betaalde versie van zijn chatbot ChatGPT. Dat meldde Tweakers onlangs. Momenteel is de chatbot gratis maar niet voor bedrijfsdoeleinden inzetbaar (wat natuurlijk geen hond tegenhoudt om er zakelijk gebruik van te maken). Het onderscheid zal vooral zitten in beschikbaarheid, snelheid en meer berichten per minuut. Het riep wel vele vragen op, die in de comments mooi samengevat werden als “Hoe wordt er in de professionele variant rekening gehouden met data die proprietary is of waar, op zijn minst, een copyright op berust?”

OpenAI werkt aan een zakelijke, betaalde versie van zijn chatbot ChatGPT. Dat meldde Tweakers onlangs. Momenteel is de chatbot gratis maar niet voor bedrijfsdoeleinden inzetbaar (wat natuurlijk geen hond tegenhoudt om er zakelijk gebruik van te maken). Het onderscheid zal vooral zitten in beschikbaarheid, snelheid en meer berichten per minuut. Het riep wel vele vragen op, die in de comments mooi samengevat werden als “Hoe wordt er in de professionele variant rekening gehouden met data die proprietary is of waar, op zijn minst, een copyright op berust?”

Het GPT-3 taalmodel waar de chatbot mee werkt, is getraind op vele miljarden tekstvoorbeelden. Het doel is leren wat het meest logische volgende woord is – kort gezegd – op basis van een prompt en de reeds gegeven woorden. Dat is met genoeg voorbeelden prima mogelijk, zeker op het niveau van chats waarbij je een vraag moet beantwoorden. ChatGPT produceert dan ook verbluffend goede resultaten, hoewel er ook volkomen waanzinnige reacties tussen zitten die met de grootste overtuiging worden gebracht.

Die tekstvoorbeelden komen natuurlijk van internet, ‘gewoon’ met een crawler die heel internet downloadt en daar machine-leesbare chocola van maakt. De makers leggen uit dat ze meer dan een biljoen (Amerikaans trillion, 1012) woorden hebben verwerkt. Dat kan niet anders dan zonder toestemming, maar iedereen stelt dat dit onder fair use te rechtvaardigen is en weet bovendien dat het ontzettend moeilijk is aan te tonen dat specifiek iemands werk opgenomen is in de dataset, plus dat een rechtszaak om dít punt uit te vechten veel te duur is voor iedere individuele rechthebbende. Uitgesloten is het niet – zie de rechtszaak over CoPilot, waarbij software-eigenaren wel degelijk zagen hoe deze AI-tool herkenbare fragmenten uit hun werk reproduceerde als “AI-generated”.

In de VS zou er misschien nog een lichtpuntje zijn wanneer je aannemelijk kunt maken dat jouw werk is gebruikt, omdat je dan via de zogeheten discovery procedure inzage kunt krijgen in documentatie rondom de bronbestanden. Dan heb je in ieder geval het feitelijke bewijs dat jouw werk is gebruikt. Vervolgens zit je nog met het juridische punt of het inbreuk is om een AI te trainen op jouw data, of dat het pas inbreuk is als de AI jouw werk reproduceert (dat laatste lijkt me evident).

In het auteursrecht geldt nu eenmaal de regel dat het bronwerk herkenbaar terug moet komen in het beweerdelijk inbreukmakende werk. Als ik iemands artikel lees en me laat inspireren tot een hoofdstuk in een boek, dan schend ik geen auteursrechten, hooguit pleeg ik academisch plagiaat. Maar als ik het artikel min of meer naschrijf, dan komt het auteursrecht wel om de hoek kijken. De academische grap is dan ook: één bron gebruiken is plagiaat, honderd bronnen gebruiken is onderzoek. En laat AI nou dus heel duidelijk die laatste kant op gaan: als honderd bronnen gebruiken mag, dan zal varen op honderd miljoen bronnen toch zeker ook wel mogen.

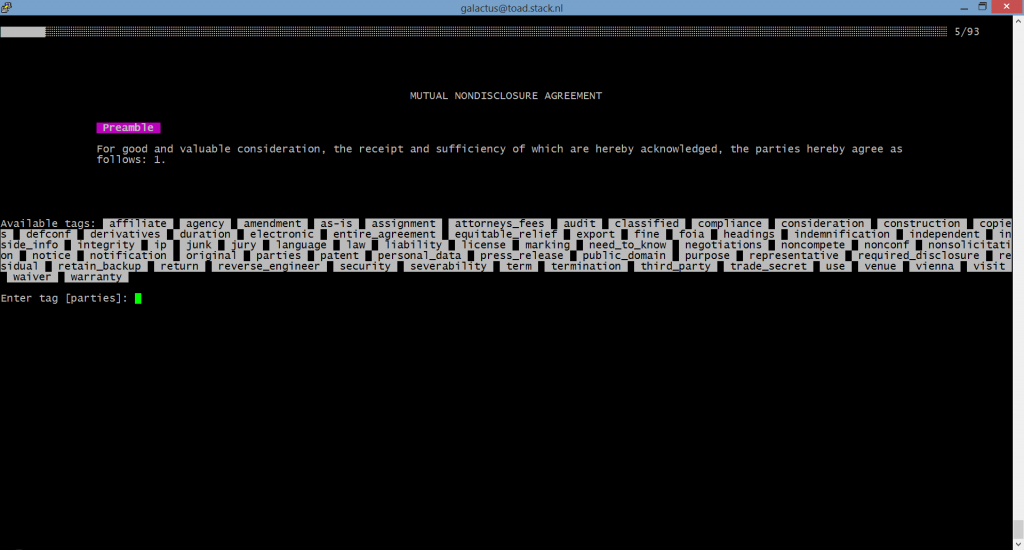

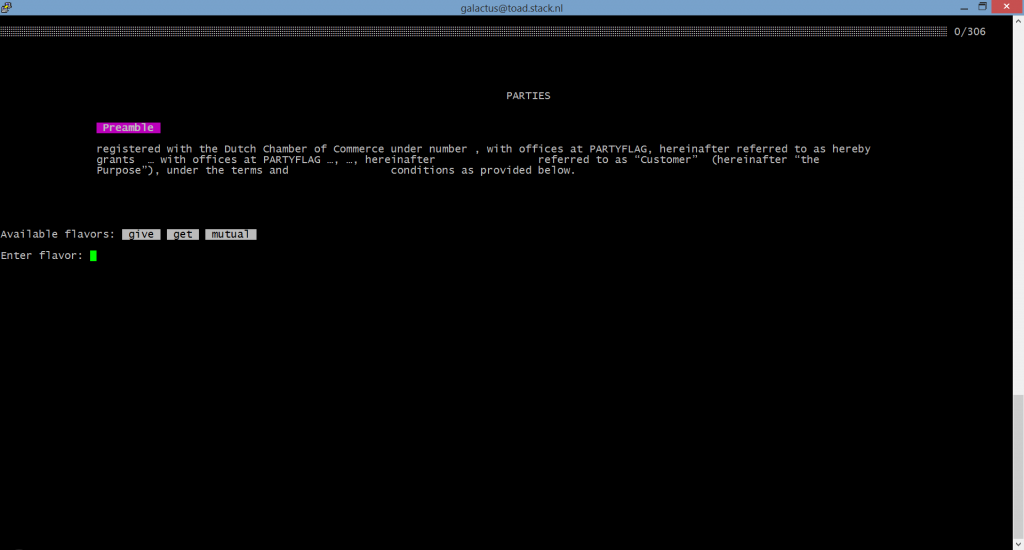

Het nieuwe aan de discussie is vooral dat we nu een betaalde dienst krijgen met een SLA. Afnemers daarvan zullen meer garanties gaan eisen, waaronder dus met name een vrijwaring (indemnification) tegen claims van derden. Want als ik als rechthebbende lees dat er ergens een adviesbureau komt dat een juridische chatbot heeft, dan ga ik die natuurlijk aanklagen en niet OpenAI uit San Francisco. Want ik durf de stelling wel aan dat mijn blog ergens in die dataset zit. Dat bureau heeft dan een probleem, want die is zelfstandig aansprakelijk. Dus dan moeten ze OpenAI zo ver krijgen de verdediging te gaan voeren, en dan wordt het een groot verhaal waar best wat nuttige puntjes uit te slepen zijn.

Arnoud

GitHub heeft een technische preview uitgebracht van Copilot, een AI-gedreven pair programmer die ontwikkelaars helpt bij het schrijven van code. Dat

GitHub heeft een technische preview uitgebracht van Copilot, een AI-gedreven pair programmer die ontwikkelaars helpt bij het schrijven van code. Dat  Twee jaar geleden parkeerde rechtenhoogleraar Corien Prins haar auto in de Utrechtsestraat in het centrum van Tilburg, zo

Twee jaar geleden parkeerde rechtenhoogleraar Corien Prins haar auto in de Utrechtsestraat in het centrum van Tilburg, zo

Medewerkers van Google luisteren gesprekken mee die Nederlanders voeren met hun slimme Google-assistent, zonder dat Google daar vooraf duidelijkheid over geeft. Dat

Medewerkers van Google luisteren gesprekken mee die Nederlanders voeren met hun slimme Google-assistent, zonder dat Google daar vooraf duidelijkheid over geeft. Dat  Facebook overtreedt mogelijk de Europese privacyverordening AVG door medewerkers van daarvoor aangestelde bedrijven te laten kijken naar posts om ze te labelen. Dat

Facebook overtreedt mogelijk de Europese privacyverordening AVG door medewerkers van daarvoor aangestelde bedrijven te laten kijken naar posts om ze te labelen. Dat  De inlichtingendiensten AIVD en MIVD gaan “rechtmatig” om met datasets met persoonsgegevens die online worden aangeboden.

Dat

De inlichtingendiensten AIVD en MIVD gaan “rechtmatig” om met datasets met persoonsgegevens die online worden aangeboden.

Dat  Een lezer vroeg me:

Een lezer vroeg me: