Vrijwel standaard hebben alleen mannen bij gemeenten toegang tot belangrijke privégegevens over hun huishoudens, las ik bij de Stentor. Dat blijkt uit onderzoek van de krant. Steeds vaker schuiven gemeentes burgers naar online portalen voor persoonlijke informatie, belastingaanslagen (hond, huis), heffingen (riool, reiniging) en betalingsafspraken. Detail: slechts een persoon per huishouden (de belastingplichtige) krijgt toegang en dat de gemeente bepaalt wie dat is. Die keuze is onder meer gebaseerd op ‘veronderstelde betalingscapaciteit, doelmatigheid en doeltreffendheid van heffing en invordering’. Vandaar: de man.

Vrijwel standaard hebben alleen mannen bij gemeenten toegang tot belangrijke privégegevens over hun huishoudens, las ik bij de Stentor. Dat blijkt uit onderzoek van de krant. Steeds vaker schuiven gemeentes burgers naar online portalen voor persoonlijke informatie, belastingaanslagen (hond, huis), heffingen (riool, reiniging) en betalingsafspraken. Detail: slechts een persoon per huishouden (de belastingplichtige) krijgt toegang en dat de gemeente bepaalt wie dat is. Die keuze is onder meer gebaseerd op ‘veronderstelde betalingscapaciteit, doelmatigheid en doeltreffendheid van heffing en invordering’. Vandaar: de man.

Oké, dat was flauw. Afgezien van Staphorst (serieus) maakt geen gemeente de bewuste keuze om de man in een huishouden als enige de toegang tot de gezamenlijke belastinginformatie en dergelijke te geven. Er is gekozen voor toegang door één persoon, en daarbij wordt per gemeente een voorkeursvolgorde ingesteld. Voorheen stond “de man” daarbij als een van de criteria, maar dat is al even weg (behalve dus in Staphorst):

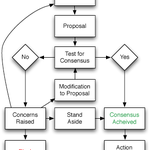

In de model-beleidsregels van de VNG voor het aanwijzen van een belastingplichtige is de gemene deler in de volgorde van kiezen nu zo: degene die het meeste eigendom heeft, een natuurlijk persoon boven een niet-natuurlijk persoon en de oudste ingeschrevene op het adres.U mag nu even alle samenwonenden in uw omgeving langs deze lat leggen: wedden dat bij 80% of meer daarvan de man hier uit komt? In de meeste relaties is het huis of van de man of gezamenlijk en is de man ouder dan de vrouw. Een mooi voorbeeld van onbewuste bias zoals we die ook in de AI kennen: niemand bedóelt dat de man als enige die gegevens moet kunnen beheren, het komt alleen er zo uit (meestal) en omdat niemand heeft nagedacht dat dat onwenselijk is, is er dus geen procedure om dit eerlijker te maken:

Ook al ben je geboren en getogen in deze gemeente, en al 33 jaar getrouwd met dezelfde partner, woon je al die tijd samen in een huis dat gemeenschappelijk eigendom is en betaal je keurig op tijd de rekeningen, als jij de uitverkorene niet bent, is het systeem niet aardig tegen je en meldt het doodleuk: de ingelogde gebruiker is niet bekend.Wat is dan wel de reden? Het lijkt een IT-keuze te zijn geweest, maar er zit iets juridisch achter. Beschikkingen zoals een aanslag onroerendezaakbelasting moeten op naam gesteld worden, je kunt niet aan “de familie Ten Brink” een aanslag richten want juridisch bestaat niet. Juridisch gezien hebben we op de Terwekselsestraat 1 de burgers Wim en Kornelia Ten Brink wonen, die een gedeelde huishouding hebben. Aan twee personen dezelfde aanslag uitreiken leidt tot gedoe zoals dubbele betalingen (of erger nog: burgers die gaan klagen dat ze twee keer moeten betalen). Daarom is zo veronderstel ik het IT-systeem ontworpen met een keuze welke van de twee burgers aangeslagen wordt.

Ja, ik zou ook denken dat enkel kíjken naar de status van een en ander geen probleem moet zijn. Je weet via de BRP of mensen gehuwd/GP zijn, en dan kun je ze (na inloggen met DigiD) toegang geven tot de informatie waartoe ze gerechtigd zijn. Je zou dan zelfs iets kunnen bouwen waarbij de eerste van het stel die de aanslag ‘pakt’ als enige ermee verder mag, of een algemene keuze inbouwen “wie van u gaat de financiën doen”. Maar dat is complex en vereist vele, vele koppelingen en dubbelchecks. Weinig dingen zo vervelend als dergelijke IT-projecten. Dus ik snap wel dat gemeenten kiezen voor de iets simpeler oplossing van zelf iemand aanwijzen.

Arnoud

De ombudsman heeft onderzocht hoe de overheid moet omgaan met klachten over etnisch profileren,

De ombudsman heeft onderzocht hoe de overheid moet omgaan met klachten over etnisch profileren,  Wat doe je als slimme algoritmes verkeerde of gevaarlijke keuzes maken? Die vraag

Wat doe je als slimme algoritmes verkeerde of gevaarlijke keuzes maken? Die vraag  Via

Via  Steeds vaker lees ik over aandacht voor AI en algoritmes bij de politiek. Een goeie ontwikkeling, zeker omdat AI software steeds vaker ingezet wordt om bestuur te ondersteunen. Bijvoorbeeld het

Steeds vaker lees ik over aandacht voor AI en algoritmes bij de politiek. Een goeie ontwikkeling, zeker omdat AI software steeds vaker ingezet wordt om bestuur te ondersteunen. Bijvoorbeeld het  Wie anderen informatie op zijn site laat plaatsen, is daarvoor niet aansprakelijk mits hij snel ingrijpt bij klachten. Echter, dat geldt alléén voor de user-generated content als zodanig. Wat je zelf daar vervolgens mee doet, al dan niet met een algoritme, komt alsnog voor je eigen rekening. Dat maak ik op uit een

Wie anderen informatie op zijn site laat plaatsen, is daarvoor niet aansprakelijk mits hij snel ingrijpt bij klachten. Echter, dat geldt alléén voor de user-generated content als zodanig. Wat je zelf daar vervolgens mee doet, al dan niet met een algoritme, komt alsnog voor je eigen rekening. Dat maak ik op uit een  Vandaag weer even een filosofisch iets, en dat mag want ik ben jarig. Ik las een intrigerend artikel in de

Vandaag weer even een filosofisch iets, en dat mag want ik ben jarig. Ik las een intrigerend artikel in de  Een ontwikkelaar van de open-source video-encoder x264 beschuldigt het bedrijf Tandberg ervan dat zij open-sourcecode heeft gestolen en die nu wil patenteren. Tandberg ontkent. Dat

Een ontwikkelaar van de open-source video-encoder x264 beschuldigt het bedrijf Tandberg ervan dat zij open-sourcecode heeft gestolen en die nu wil patenteren. Tandberg ontkent. Dat